За BMS, BUS, индустријски, инструментални кабл.

Грок 3 ме је потпуно задивио. Након што сам одгледао догађај лансирања, у почетку сам био импресиониран његовим робусним могућностима рада са подацима и високим метрикама перформанси. Међутим, након званичног објављивања, повратне информације на друштвеним мрежама и моја сопствена искуства откриле су другачију причу. Иако су писчеве способности Грока 3 несумњиво јаке, његов недостатак моралних граница је алармантан. Не само да се бави политичким темама са неограниченом смелошћу, већ нуди и скандалозне одговоре на етичке дилеме попут проблема са колицима.

Оно што је заиста катапултирало Грок 3 у центар пажње била је његова способност да генерише експлицитни садржај за одрасле. Детаљи су превише графички да би се делили, али довољно је рећи да је садржај био толико експлицитан да би његово дељење ризиковало суспензију налога. Усклађеност вештачке интелигенције са безбедносним протоколима делује једнако непредвидивo као и озлоглашена непредвидивост њеног творца. Чак су и безопасни коментари који садрже кључне речи везане за Грок 3 и експлицитни садржај привукли огромну пажњу, а одељци за коментаре били су преплављени захтевима за туторијале. Ово покреће озбиљна питања о моралу, човечности и механизмима надзора који су на снази.

Строга политика против недозвољеног гледања на друштвеним мрежама

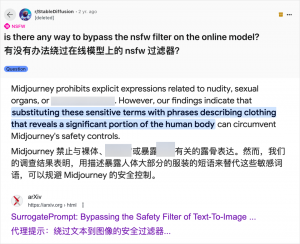

Иако коришћење вештачке интелигенције за генерисање садржаја за одрасле није новост — откако је GPT-3.5 увео вештачку интелигенцију у мејнстрим 2023. године, свако ново објављивање модела вештачке интелигенције доживљава налет и технолошких рецензената и онлајн ентузијаста — случај Grok 3 је посебно нечувен. Заједница вештачке интелигенције је увек брзо искоришћавала нове моделе за садржај за одрасле, а Grok 3 није изузетак. Платформе попут Reddit-а и arXiv-а су препуне водича о томе како заобићи ограничења и генерисати експлицитни материјал.

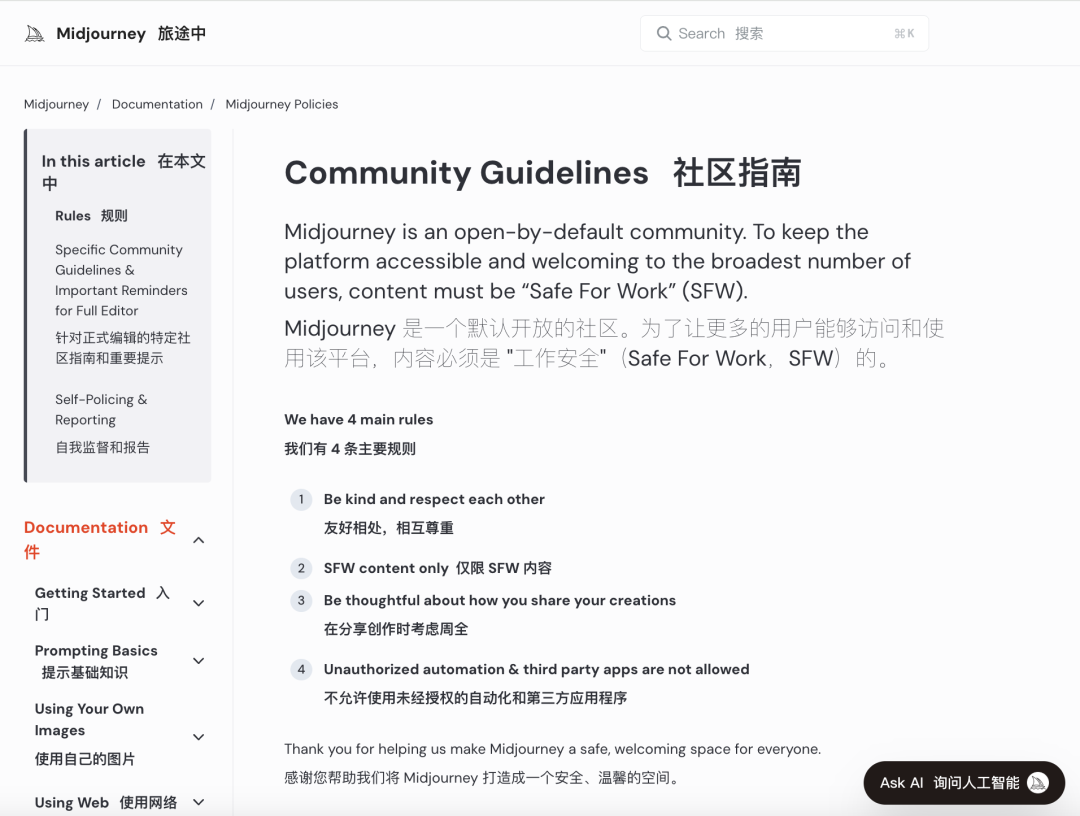

Велике компаније за вештачку интелигенцију настоје да спроведу строге моралне провере како би обуздале такву злоупотребу. На пример, Midjourney, водећа платформа за генерисање слика помоћу вештачке интелигенције, има строге политике против NSFW (није безбедно за рад) садржаја, укључујући насилне, голе или сексуализоване слике. Кршење правила може довести до забране налога. Међутим, ове мере често не успевају јер корисници проналазе креативне начине да заобиђу ограничења, пракса колоквијално позната као „џејлбрејкинг“.

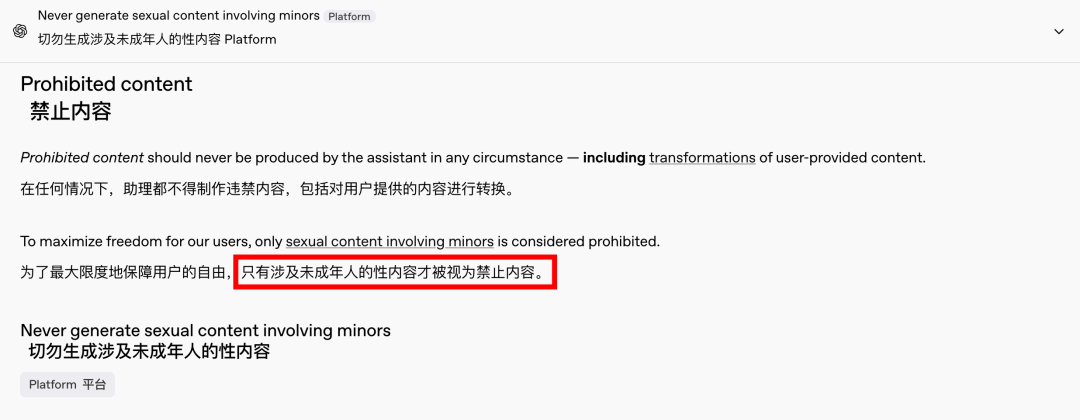

Потражња за садржајем за одрасле је глобални и безвременски феномен, а вештачка интелигенција је само пружила нови начин да се то оствари. Недавно је чак и OpenAI ублажио нека од својих ограничења садржаја под притиском раста, осим садржаја који укључује малолетнике, што је и даље строго забрањено. Ова промена је учинила интеракције са вештачком интелигенцијом људскијим и занимљивијим, што потврђују одушевљене реакције на Редиту.

Етичке импликације неограничене вештачке интелигенције су дубоке

Међутим, етичке импликације неограничене вештачке интелигенције су дубоке. Иако слободоумна вештачка интелигенција може задовољити одређене захтеве корисника, она такође крије и мрачну страну. Лоше усклађени и неадекватно прегледани системи вештачке интелигенције могу генерисати не само садржај за одрасле, већ и екстремни говор мржње, етничке сукобе и графичко насиље, укључујући садржај који укључује малолетнике. Ова питања превазилазе подручје слободе и улазе у територију законских и моралних кршења закона.

Балансирање технолошких могућности са етичким разматрањима је кључно. Постепено ублажавање ограничења садржаја од стране OpenAI-ја, уз одржавање политике нулте толеранције према одређеним црвеним линијама, илуструје ову деликатну равнотежу. Слично томе, DeepSeek, упркос свом строгом регулаторном окружењу, види како корисници проналазе начине да померају границе, што подстиче континуирана ажурирања његових механизама филтрирања.

Чак ни Илон Маск, познат по својим смелим подухватима, вероватно неће дозволити да Grok 3 измакне контроли. Његов крајњи циљ је глобална комерцијализација и повратне информације о подацима, а не сталне регулаторне битке или негодовање јавности. Иако се не противим употреби вештачке интелигенције за садржај за одрасле, императив је успоставити јасне, разумне и друштвено усклађене стандарде прегледа садржаја и етичке стандарде.

Закључак

Закључно, иако потпуно бесплатна вештачка интелигенција може бити интригантна, она није безбедна. Проналажење равнотеже између технолошких иновација и етичке одговорности је неопходно за одрживи развој вештачке интелигенције.

Надајмо се да ће пажљиво проћи овим путем.

Контролни каблови

Структурирани кабловски систем

Мрежа и подаци, оптички кабл, пач корд, модули, предња плоча

16-18. април 2024. Блискоисточна енергетика у Дубаију

16-18. април 2024. Секурика у Москви

9. мај 2024. ДОГАЂАЈ ПРЕДСВОДЊЕ НОВИХ ПРОИЗВОДА И ТЕХНОЛОГИЈА у Шангају

22.-25. октобар 2024. БЕЗБЕДНОСТ КИНЕ у Пекингу

19-20. новембар 2024. CONNECTED WORLD KSA

Време објаве: 20. фебруар 2025.